▲美国汉森机器人公司生产的机器人索菲亚,其“大脑”采用了人工智能和谷歌语音识别技术,能识别人类面部、理解语言、记住与人类的互动。 (图片来自网络)

“机器人能够明辨是非吗?”——随着人工智能的高歌猛进,机器人伦理正成为学术界与技术界的热议话题,而不少普通人也表示好奇:“机器人能懂得这种谦让或者分寸的把握吗?向机器人植入人类的价值观是否可能?”

也许在多数人看来,让机器人懂得道德对错是不可思议的。然而,耶鲁大学教授,人工智能和神经科学伦理学专家温德尔?瓦拉赫却开创性地提出了让机器人明辨是非的途径。

▲温德尔?瓦拉赫教授在发表演讲。(北京大学出版社供图)

5月20日,在由北京大学出版社、北大博雅讲坛主办的“机器人能够明辨是非吗——人工智能伦理道德的未来走向”讲座论坛暨《道德机器:如何让机器人明辨是非》的作者见面会上,温德尔?瓦拉赫就其与科林?艾伦合著的新书《道德机器》中的内容进行了概要阐释,并就人工智能伦理道德等前沿问题与现场嘉宾、读者做了深度交流。他指出,尽管完备的机器道德智能体还很遥远,但是目前有必要,而且有可能开始建构一种功能性道德,即人工道德智能体(Artificial Moral Agents [AMAs]),让人工智能具有基本的道德敏感性。

如何让机器人明辨是非:已成为不亚于发展人工智能本身的当务之急

▲电影《银翼杀手》剧照。在《银翼杀手》中,一方面人类试图消灭由自己亲手制造出的在各方面都强于自己的复制人,另一方面复制人为了生存的权利展开了与人的斗争。(图片来自网络)

人工智能已渗入到了我们日常生活的诸多方面。一方面,“语音识别、人脸识别、围棋对弈、无人驾驶、机器翻译……”等一系列应用成果让人目不暇接,另一方面,有关人工智能的负面影响也频见媒体报端,不少人担忧人工智能滥用所带来的道德风险。

因此,在一些科学人士看来,树立和规范人工智能道德,已成为不亚于发展人工智能本身的当务之急。

可是,要如何教会没有意志、情感、态度的机器人明辨人类的是非呢?

▲温德尔?瓦拉赫教授与现场嘉宾交谈(摄/彭丹)

“机器有两种办法习得道德,” 温德尔?瓦拉赫在讲座中介绍道:“一是自上而下,一个是自下而上。自上而下就是把人类已经成熟的伦理系统、道德理论体系灌输进去,如康德的绝对律令、阿西莫夫提出的机器人三定律”。

“自下而上是指创造一个环境、生态能让智能体探索自己的行为方式、去学习,在作出道德上值得赞扬的行为时适时得到奖赏,并将这种是非观念和行为模式稳定下来”。

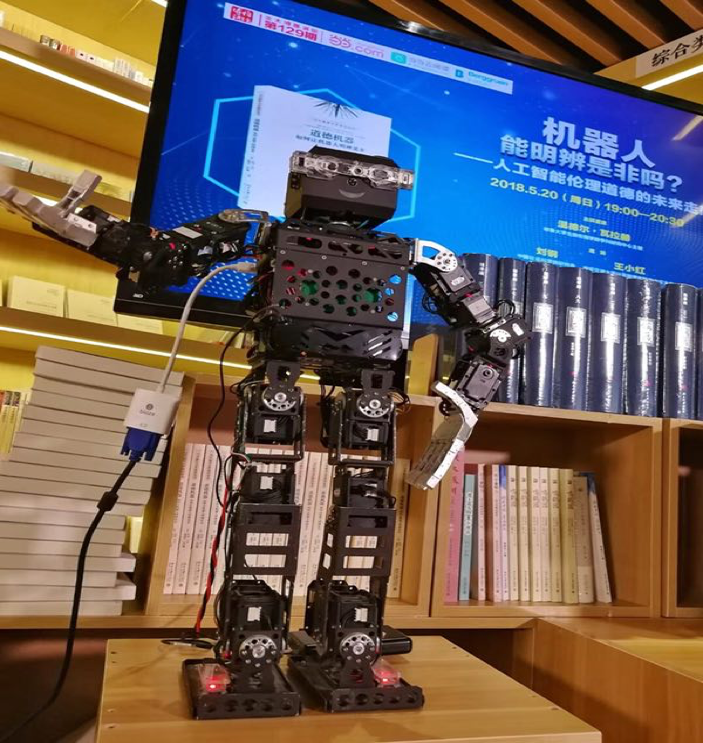

▲讲座现场的语音机器人(北京大学出版社供图)

在温德尔?瓦拉赫看来,这两种路径各有优劣:“比如自上而下虽然能够用很简明扼要的律令、道德规则来约束机器人,但不同的伦理道德体系实际上也是会产生冲突的,即使是同一个道德伦理体系,如果要是将其算法化、程序化,也会有可行性等问题”。同样地,自下而上的途径也存在无法获取安全保障等问题。

虽然“很难有完备的解决方案,但让机器人具备基本的道德敏感性是可能的”。温德尔?瓦拉赫的结论和倡议是,应该把这两种路径结合起来,“在基于开放性、交互性的前提下,逐步使人工智能和机器具备道德决策能力”。这也是《道德机器——如何让机器人明辨是非》一书的核心观点。

“实际上,人自身都很难辨别道德”

▲电影《黑客帝国》海报。在电影展示的未来世界中,人类生活由名叫“母体”的计算机人工智能系统所控制,人类沦为人工智能饲养的动物,没有自由和思想。(图片来自网络)

温德尔?瓦拉赫的讲座受到了现场嘉宾和观众的热烈反馈。在提问环节,不少观众抛出了有关人工智能领域的尖锐问题,让温德尔?瓦拉赫教授大呼有趣。

比如有位观众问道:“假如遇到囚徒困境,应该让机器怎么应对呢?”

“我们人类太蠢了,” 温德尔?瓦拉赫笑答,“如果遇到囚徒困境,两个人背靠背去做选择,结果一定是都背叛对方。但机器没有自私这一说,我们设计的人工道德智能体一定要让它们在这种情形下合作”。

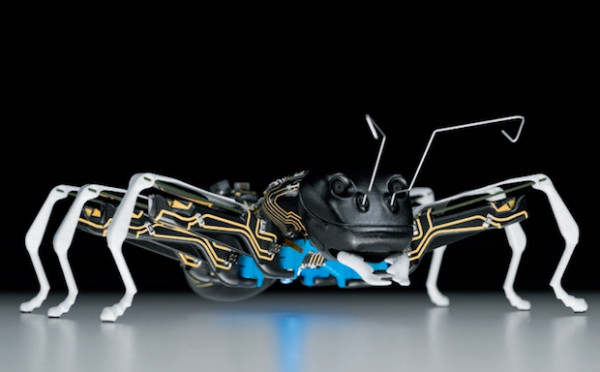

▲气动业全球领先厂商德国Festo制造的仿生蚂蚁机器人,如同真正的蚂蚁,这些仿生蚂蚁可以遵守简单规则、自主自动,在同一时间协同合作,完成大规模且复杂的任务。( 图片来自网络)

还有观众大胆地对瓦拉赫教授的观点提出了异议:“我认为和人类道德一样,未来机器道德体系形成必须是自下而上的演化过程。自上而下,自下而上结合的话必然产生矛盾,不知道教授怎么看待我的观点?”

温德尔?瓦拉赫表示尊重这一看法,但他本人仍坚持将自上而下与自下而上相结合,实际上“要让机器辨别道德是件复杂的事情。人自身都很难辨别道德,人类道德本身还亟待说明和完善”。

正如与会嘉宾之一,博古睿研究中心的主任宋冰所言:“温德尔?瓦拉赫的这本书探索是没有定论的,他提出的问题可能比回答的问题还多,但是这并不是他学术上的瑕疵,这正反映了他学术上的诚实和知难而上的探索精神”。

▲现场观众踊跃提问(摄/彭丹)

作者:本报实习生 彭丹

编辑制作:江胜信

*文汇独家稿件,转载请注明出处。